La semana pasada, los investigadores de Apple presentaron OpenELM, una serie de " modelos lingüísticos eficientesde código abierto", sobre la biblioteca de modelos Hugging Face. Las cuatro variantes tienen un tamaño que oscila entre los 270 millones de parámetros y los 3.000 millones, y son los candidatos más probables para la IA en los dispositivos Apple.

Para contextualizar, Apple lanzó discretamente un marco de aprendizaje automático llamado MLX en diciembre de 2023. El siguiente fue Edición de imágenes guiada por MLLM (MGIE)seguido de una sucesión de iniciativas de IA generativa, como Keyframer, Ferret-UI y AI para completar código en Xcode. En su mayor parte, estos proyectos aprovechan la potencia de procesamiento del silicio de Apple en lugar de descargar la funcionalidad de la IA a la nube.

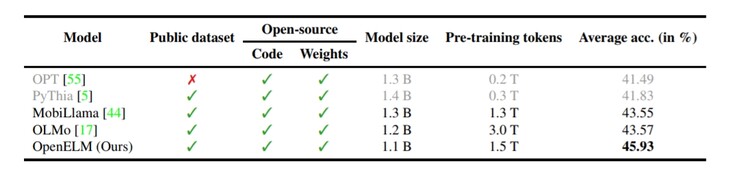

En la misma línea, OpenELM representa el enfoque en el dispositivo de Apple hacia la IA. Normalmente, los LLM públicos utilizan cientos de miles de millones (a veces billones) de variables para comprender la entrada del usuario y decidir una respuesta adecuada. Por otro lado, los modelos lingüísticos más pequeños, como Phi-3 de Microsoft, utilizan tan sólo 3.800 millones de parámetros, mientras que Google Gemma presume de 2.000 millones. Sin embargo, debido al enfoque único de OpenELM respecto a la arquitectura del modelo de transformación, el modelo toca fondo con sólo 270 millones de parámetros.

Obviamente, ser pequeño tiene algunos inconvenientes. Por un lado, OpenELM no es multimodal, ya que tiene muy pocos parámetros para que eso sea factible. Además, su conocimiento de los hechos es bastante escaso, como demuestra el informe técnico https://www.google.com/url?sa=t&source=web&rct=j&opi=89978449&url=https://arxiv.org/abs/2404.14619&ved=2ahUKEwjthIWbmeyFAxXMXEEAHeVICrgQFnoECBQQAQ&usg=AOvVaw0lkrTbxKNgbdUB4po5zOEa . Este problema aqueja a todos los LLM públicos de tamaño similar. Sin embargo, su pequeño tamaño permite alojar el modelo de IA localmente en teléfonos u ordenadores portátiles en lugar de en la nube.

Applela publicación pública de OpenELM por parte de la empresa se aparta de sus prácticas habituales. Desde el marco completo y la evaluación del modelo, hasta los registros de entrenamiento, las configuraciones de preentrenamiento y el código de inferencia MLX, cada aspecto del modelo lingüístico está disponible públicamente a través de Hugging Face para que los desarrolladores puedan retocarlo y reutilizarlo para diferentes casos de uso. Ostensiblemente, un lanzamiento tan extenso debería reforzar la apuesta de Apple por la IA inspirando a los investigadores a jugar con las posibilidades de los dispositivos Apple.

Pero hay otros actores en este espacio. El Phi-3 de Microsoft es un rival muy competente, al igual que los demás proyectos abiertos de LLM de Redmond. El Gemma 2B - 3B de Google es otro. Aunque todos los modelos mencionados todavía funcionan con demasiada lentitud, el hardware y el software se están moviendo sin duda en las direcciones correctas para los modelos de lengua pequeña.

Por ahora, los dispositivos edge como el Samsung Galaxy S24 (a partir de 799 dólares en Amazon), o el OnePlus 12R que utiliza el procesador interno Andes-GPT tienen que depender del procesamiento en la nube. Tanto si Apple incorpora OpenELM en el próximo iPhone como si no, es probable que la empresa con sede en Cupertino colabore con Google o con Open AI para funciones de IA generativa más pesadas.

Fuente(s)

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck