OpenAI ha dado a conocer su último modelo de gran lenguaje de IA, o3-mini, que es más rápido y mejor que su predecesor o1-mini a la hora de proporcionar respuestas precisas. Este modelo es el primer LLM de razonamiento pequeño de la empresa disponible hoy para uso público y gratuito de todos los titulares de cuentas ChatGPT.

El modelo o3-mini puede ejecutarse utilizando tres niveles de esfuerzo de razonamiento: bajo, medio y alto. Cualquiera que tenga una cuenta ChatGPT gratuita puede ejecutar o3-mini gratis en el nivel de razonamiento medio, mientras que los titulares de cuentas de pago pueden elegir los niveles de razonamiento bajo o alto. Los usuarios de pago de ChatGPT Plus, Team y Pro tienen acceso inmediato a o3-mini desde hoy, mientras que los usuarios de Enterprise deberán esperar hasta febrero. Los programadores que estén ansiosos por crear aplicaciones de éxito impulsadas por la API de o3-mini de OpenAI pueden leer cómo hacerlo con este libro en Amazon.

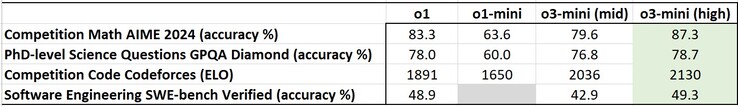

En general, o3-mini, cuando se configura en modo de razonamiento medio o alto, supera a o1-mini en los puntos de referencia de IA estandarizados, incluidos aquellos que exigen a la IA que razone los problemas. Cuando se configura en modo de razonamiento alto, o3-mini también consigue superar al modelo más grande o1 en algunos puntos de referencia, pero carece de la capacidad de o1 para ver imágenes y procesar datos visuales.

En particular, o3-mini proporciona respuestas un 24%, o unos 2,46 segundos, más rápido que o1-mini. Esto ayuda a reducir el tiempo de espera para que ChatGPT proporcione respuestas y las emisiones de carbono producidas por los ordenadores que ejecutan o3-mini. Aunque es más rápido, los piratas informáticos se sentirán decepcionados con o3-mini porque su capacidad para ser utilizado en ataques de ciberseguridad ha quedado muy neutralizada.

31 de enero de 2025

OpenAI o3-mini

Empujando la frontera del razonamiento rentable.

Hoy lanzamos OpenAI o3-mini, el modelo más nuevo y rentable de nuestra serie de razonamiento, disponible tanto en ChatGPT como en la API. Presentado en diciembre de 2024, este modelo potente y rápido avanza los límites de lo que pueden lograr los modelos pequeños, ofreciendo capacidades STEM excepcionales -con especial fuerza en ciencias, matemáticas y codificación-, todo ello manteniendo el bajo coste y la latencia reducida de OpenAI o1-mini.

OpenAI o3-mini es nuestro primer modelo de razonamiento pequeño que admite características muy solicitadas por los desarrolladores, como la llamada a funciones(se abre en una ventana nueva), las salidas estructuradas(se abre en una ventana nueva) y los mensajes de desarrollador(se abre en una ventana nueva), lo que lo hace listo para la producción desde el principio. Al igual que OpenAI o1-mini y OpenAI o1-preview, o3-mini soportará streaming(abre en una nueva ventana). Además, los desarrolladores pueden elegir entre tres opciones de esfuerzo de razonamiento(opens in a new window) -bajo, medio y alto- para optimizarlo para sus casos de uso específicos. Esta flexibilidad permite a o3-mini "pensar más" cuando aborda retos complejos o priorizar la velocidad cuando la latencia es una preocupación. o3-mini no es compatible con las capacidades de visión, por lo que los desarrolladores deben seguir utilizando OpenAI o1 para las tareas de razonamiento visual. o3-mini se está desplegando en la API de finalización de chat, la API de asistentes y la API de lotes a partir de hoy para desarrolladores seleccionados en los niveles de uso de la API 3-5(se abre en una ventana nueva).

Los usuarios de ChatGPT Plus, Team y Pro pueden acceder a OpenAI o3-mini a partir de hoy, y el acceso Enterprise llegará en febrero. o3-mini sustituirá a OpenAI o1-mini en el selector de modelos, ofreciendo mayores límites de velocidad y menor latencia, lo que la convierte en una opción convincente para tareas de codificación, STEM y resolución de problemas lógicos. Como parte de esta actualización, estamos triplicando el límite de tasa para los usuarios Plus y Team, de 50 mensajes al día con o1-mini a 150 mensajes al día con o3-mini. Además, o3-mini funciona ahora con la búsqueda para encontrar respuestas actualizadas con enlaces a fuentes web relevantes. Se trata de un prototipo inicial mientras trabajamos para integrar la búsqueda en todos nuestros modelos de razonamiento.

A partir de hoy, los usuarios del plan gratuito también pueden probar OpenAI o3-mini seleccionando "Razonar" en el compositor de mensajes o regenerando una respuesta. Es la primera vez que un modelo de razonamiento se pone a disposición de los usuarios gratuitos en ChatGPT.

Mientras que OpenAI o1 sigue siendo nuestro modelo de razonamiento de conocimiento general más amplio, OpenAI o3-mini proporciona una alternativa especializada para dominios técnicos que requieren precisión y velocidad. En ChatGPT, o3-mini utiliza un esfuerzo de razonamiento medio para ofrecer una compensación equilibrada entre velocidad y precisión. Todos los usuarios de pago tendrán también la opción de seleccionar o3-mini-high en el selector de modelos para una versión de mayor inteligencia que tarda un poco más en generar respuestas. Los usuarios Pro tendrán acceso ilimitado tanto a o3-mini como a o3-mini-high.

Rápido, potente y optimizado para el razonamiento STEM

Al igual que su predecesor OpenAI o1, OpenAI o3-mini ha sido optimizado para el razonamiento STEM. o3-mini con un esfuerzo de razonamiento medio iguala el rendimiento de o1 en matemáticas, codificación y ciencias, a la vez que ofrece respuestas más rápidas. Las evaluaciones realizadas por probadores expertos mostraron que o3-mini produce respuestas más precisas y claras, con mayores capacidades de razonamiento, que OpenAI o1-mini. Los probadores prefirieron las respuestas de o3-mini a las de o1-mini el 56% de las veces y observaron una reducción del 39% de los errores importantes en preguntas difíciles del mundo real. Con un esfuerzo de razonamiento medio, o3-mini iguala el rendimiento de o1 en algunas de las evaluaciones de razonamiento e inteligencia más exigentes, como AIME y GPQA.

Competencia matemática (AIME 2024)

El gráfico de barras compara la precisión en las preguntas de matemáticas de la competición AIME 2024 entre los distintos modelos de IA. Los modelos más antiguos (gris) obtienen puntuaciones más bajas, mientras que los más nuevos (amarillo) mejoran. "o3-mini (alto)" alcanza la mayor precisión con un 83,6%, lo que muestra un progreso significativo.

Matemáticas: Con un esfuerzo de razonamiento bajo, la OpenAI o3-mini alcanza un rendimiento comparable al de la OpenAI o1-mini, mientras que con un esfuerzo medio, la o3-mini alcanza un rendimiento comparable al de la o1. Mientras tanto, con un esfuerzo de razonamiento alto, o3-mini supera tanto a OpenAI o1-mini como a OpenAI o1, donde las regiones sombreadas en gris muestran el rendimiento del voto mayoritario (consenso) con 64 muestras.

Preguntas científicas a nivel de doctorado (GPQA Diamond)

El gráfico de barras compara la precisión en las preguntas científicas de nivel de doctorado (GPQA Diamond) entre los distintos modelos de IA. Los modelos más antiguos (gris) obtienen peores resultados, mientras que los más recientes (amarillo) mejoran. "o3-mini (high)" alcanza un 77,0% de precisión, lo que muestra un notable progreso respecto a las versiones anteriores.

Ciencia a nivel de doctorado: En preguntas de biología, química y física de nivel de doctorado, con un esfuerzo de razonamiento bajo, OpenAI o3-mini alcanza un rendimiento superior a OpenAI o1-mini. Con un esfuerzo elevado, o3-mini alcanza un rendimiento comparable al de o1.

FrontierMath

Una cuadrícula negra con múltiples filas y columnas, separadas por finas líneas blancas, que crean un diseño estructurado y organizado.

Matemáticas de nivel de investigación: La OpenAI o3-mini con razonamiento elevado obtiene mejores resultados que su predecesora en FrontierMath. En FrontierMath, cuando se le pide que utilice una herramienta Python, o3-mini con alto esfuerzo de razonamiento resuelve más del 32% de los problemas en el primer intento, incluyendo más del 28% de los problemas difíciles (T3). Estas cifras son provisionales, y el gráfico anterior muestra el rendimiento sin herramientas ni calculadora.

Código de competición (Codeforces)

El gráfico de barras compara las puntuaciones Elo en las tareas de codificación de competición de Codeforces entre los distintos modelos de IA. Los modelos más antiguos (gris) obtienen puntuaciones más bajas, mientras que los más nuevos (amarillo) mejoran. "o3-mini (alta)" alcanza 2073 Elo, lo que muestra un progreso significativo respecto a las versiones anteriores.

Codificación de competición: En la programación competitiva Codeforces, OpenAI o3-mini alcanza puntuaciones Elo progresivamente más altas con un mayor esfuerzo de razonamiento, superando en todos los casos a o1-mini. Con un esfuerzo de razonamiento medio, iguala el rendimiento de o1.

Ingeniería de software (SWE-bench Verified)

El gráfico de barras compara la precisión en las tareas de ingeniería de software verificadas por SWE-bench entre los modelos de IA. Los modelos más antiguos (gris) tienen un rendimiento inferior, mientras que "o3-mini (alto)" (amarillo) alcanza la mayor precisión con un 48,9%, lo que muestra una mejora con respecto a las versiones anteriores.

Ingeniería de software: o3-mini es nuestro modelo liberado de mayor rendimiento en SWEbench-verificado. Para obtener datos adicionales sobre los resultados de SWE-bench Verified con un alto esfuerzo de razonamiento, incluso con el andamiaje de código abierto Agentless (39%) y un andamiaje de herramientas internas (61%), consulte nuestra ficha del sistema.

Codificación LiveBench

La tabla compara modelos de IA en tareas de codificación, mostrando métricas de rendimiento y puntuaciones de evaluación. Destaca las diferencias en precisión y eficacia, y algunos modelos superan a otros en puntos de referencia específicos.

Codificación LiveBench: OpenAI o3-mini supera a o1-high incluso a un esfuerzo de razonamiento medio, destacando su eficiencia en tareas de codificación. A un esfuerzo de razonamiento alto, o3-mini amplía aún más su ventaja, logrando un rendimiento significativamente mayor en las métricas clave.

Conocimientos generales

La tabla titulada "Evaluaciones por categorías" compara los modelos de IA en diferentes categorías de evaluación, mostrando las métricas de rendimiento. Destaca las diferencias en precisión, eficiencia y eficacia, y algunos modelos superan a otros en tareas específicas.

Conocimientos generales: o3-mini supera a o1-mini en las evaluaciones de conocimientos en dominios de conocimientos generales.

Evaluación de preferencias humanas

El gráfico compara los porcentajes de victorias en tareas STEM y no STEM entre los distintos modelos de IA. "o3_mini_v43_s960_j128" (amarillo) supera a "o1_mini_chatgpt" (línea de base roja) en ambas categorías, con una mayor tasa de victorias para las tareas STEM.

El gráfico compara los porcentajes de victorias con limitaciones de tiempo y los porcentajes de errores importantes entre los modelos de IA. "o3_mini_v43_s960_j128" (amarillo) supera a "o1_mini_chatgpt" (línea de base roja) en tasa de victorias y reduce significativamente los errores importantes.

Evaluación de las preferencias humanas: Las evaluaciones realizadas por probadores expertos externos también muestran que la OpenAI o3-mini produce respuestas más precisas y claras, con mayor capacidad de razonamiento que la OpenAI o1-mini, especialmente para STEM. Los probadores prefirieron las respuestas de o3-mini a las de o1-mini el 56% de las veces y observaron una reducción del 39% de los errores importantes en preguntas difíciles del mundo real.

Velocidad y rendimiento del modelo

Con una inteligencia comparable a la de OpenAI o1, OpenAI o3-mini ofrece un rendimiento más rápido y una eficiencia mejorada. Más allá de las evaluaciones STEM destacadas anteriormente, o3-mini demuestra resultados superiores en evaluaciones adicionales de matemáticas y factualidad con un esfuerzo de razonamiento medio. En las pruebas A/B, o3-mini ofreció respuestas un 24% más rápidas que o1-mini, con un tiempo medio de respuesta de 7,7 segundos frente a 10,16 segundos.

Comparación de latencia entre o1-mini y o3-mini (media)

El gráfico de barras compara la latencia entre los modelos "o1-mini" y "o3-mini (mediano)". "o3-mini" (amarillo más claro) tiene una latencia menor, lo que indica tiempos de respuesta más rápidos, mientras que "o1-mini" (amarillo más oscuro) tarda más de media.

Latencia: o3-mini tiene un tiempo medio hasta el primer token 2500 ms más rápido que o1-mini.

Seguridad

Una de las técnicas clave que utilizamos para enseñar a la OpenAI o3-mini a responder con seguridad es la alineación deliberativa, en la que entrenamos al modelo para razonar sobre las especificaciones de seguridad escritas por humanos antes de responder a las indicaciones del usuario. Al igual que OpenAI o1, comprobamos que o3-mini supera significativamente a GPT-4o en las exigentes evaluaciones de seguridad y jailbreak. Antes de su despliegue, evaluamos cuidadosamente los riesgos de seguridad de o3-mini utilizando el mismo enfoque de preparación, red-teaming externo y evaluaciones de seguridad que o1. Agradecemos a los evaluadores de seguridad que solicitaron probar o3-mini en acceso temprano. Los detalles de las evaluaciones que figuran a continuación, junto con una explicación exhaustiva de los riesgos potenciales y la eficacia de nuestras mitigaciones, están disponibles en la ficha del sistema o3-mini.

Evaluaciones de contenidos no permitidos

La tabla compara los modelos de IA en cuanto a métricas de seguridad, evaluando el rendimiento en diferentes categorías de riesgo. Destaca las variaciones en el cumplimiento de las normas de seguridad, ya que algunos modelos obtienen mejores resultados en la reducción de riesgos potenciales.

Evaluaciones de jailbreak

La tabla compara los modelos de IA en las métricas de seguridad a través de distintas categorías de riesgo, mostrando variaciones en el rendimiento. Destaca las diferencias en la mitigación de riesgos, con algunos modelos demostrando un mayor cumplimiento y respuestas más seguras.

Lo que está por venir

El lanzamiento de OpenAI o3-mini supone un paso más en la misión de OpenAI de ampliar los límites de la inteligencia rentable. Al optimizar el razonamiento para los dominios STEM manteniendo los costes bajos, estamos haciendo que la IA de alta calidad sea aún más accesible. Este modelo continúa nuestra trayectoria de abaratamiento de la inteligencia -reducción del precio por token en un 95% desde el lanzamiento de GPT-4-, manteniendo al mismo tiempo unas capacidades de razonamiento de primer nivel. A medida que se extiende la adopción de la IA, mantenemos nuestro compromiso de liderar en la frontera, construyendo modelos que equilibren inteligencia, eficiencia y seguridad a escala.

Autores

OpenAI

Formación

Brian Zhang, Eric Mitchell, Hongyu Ren, Kevin Lu, Max Schwarzer, Michelle Pokrass, Shengjia Zhao, Ted Sanders

Eval

Adam Kalai, Alex Tachard Passos, Ben Sokolowsky, Elaine Ya Le, Erik Ritter, Hao Sheng, Hanson Wang, Ilya Kostrikov, James Lee, Johannes Ferstad, Michael Lampe, Prashanth Radhakrishnan, Sean Fitzgerald, Sebastien Bubeck, Yann Dubois, Yu Bai

Evasión y preparación en las fronteras

Andy Applebaum, Elizabeth Proehl, Evan Mays, Joel Parish, Kevin Liu, Leon Maksin, Leyton Ho, Miles Wang, Michele Wang, Olivia Watkins, Patrick Chao, Samuel Miserendino, Tejal Patwardhan

Ingeniería

Adam Walker, Akshay Nathan, Alyssa Huang, Andy Wang, Ankit Gohel, Ben Eggers, Brian Yu, Bryan Ashley, Chengdu Huang, Christian Hoareau, Davin Bogan, Emily Sokolova, Eric Horacek, Eric Jiang, Felipe Petroski Such, Jonah Cohen, Josh Gross, Justin Becker, Kan Wu, Kevin Whinnery, Larry Lv, Lee Byron, Manoli Liodakis, Max Johnson, Mike Trpcic, Murat Yesildal, Rasmus Rygaard, RJ Marsan, Rohit Ramchandani, Rohan Kshirsagar, Roman Huet, Sara Conlon, Shuaiqi (Tony) Xia, Siyuan Fu, Srinivas Narayanan, Sulman Choudhry, Tomer Kaftan, Trevor Creech

Busque en

Adam Fry, Adam Perelman, Brandon Wang, Cristina Scheau, Philip Pronin, Sundeep Tirumalareddy, Will Ellsworth, Zewei Chu

Producto

Antonia Woodford, Beth Hoover, Jake Brill, Kelly Stirman, Minnia Feng, Neel Ajjarapu, Nick Turley, Nikunj Handa, Olivier Godement

Seguridad

Andrea Vallone, Andrew Duberstein, Enis Sert, Eric Wallace, Grace Zhao, Irina Kofman, Jieqi Yu, Joaquin Quinonero Candela, Madelaine Boyd, Mehmet Yatbaz, Mike McClay, Mingxuan Wang, Saachi Jain, Sandhini Agarwal, Sam Toizer, Santiago Hernández, Steve Mostovoy, Young Cha, Tao Li, Yunyun Wang

Redacción externa

Lama Ahmad, Troy Peterson

Gestores del programa de investigación

Carpo Chang, Kristen Ying

Liderazgo

Aidan Clark, Dane Stuckey, Jerry Tworek, Jakub Pachocki, Johannes Heidecke, Kevin Weil, Liam Fedus, Mark Chen, Sam Altman, Wojciech Zaremba

+ todos los colaboradores de o1.

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck