OpenAI ha presentado GPT-4o mini con un precio más de 25 veces inferior al de su GPT-4o mejor clasificada, abriendo el acceso a la IA de calidad a más empresas y usuarios. GPT-4o mini ha sido clasificado de forma independiente entre los 10 modelos de IA más capaces disponibles en la actualidad. GPT-4o mini obtiene buenos resultados en una serie de pruebas comparativas de IA a pesar de ser un modelo LLM pequeño.

Un gran modelo lingüístico (LLM) se crea tras un entrenamiento en millones de documentos y constituye la base de un chatbot de IA como ChatGPT. El modelo contiene vectores matemáticos que asocian la probabilidad de que palabras, imágenes y demás se den entre sí. Por ejemplo, la probabilidad de que "hielo" aparezca junto a "crema" es mucho mayor que la de que aparezca junto a "piedra". Sin embargo, un gran LLM utiliza mucha potencia de cálculo https://arxiv.org/pdf/2210.17331 y energía para responder a las peticiones de los usuarios, lo que equivale a un coste elevado para éstos. Recortar los LLM puede hacerlos más pequeños, baratos y ecológicos, con la contrapartida de respuestas menos precisas.

Los lectores que no sepan cómo utilizar la IA para realizar mejor las tareas empresariales o para ganar más dinero pueden leer este libro en Amazon.

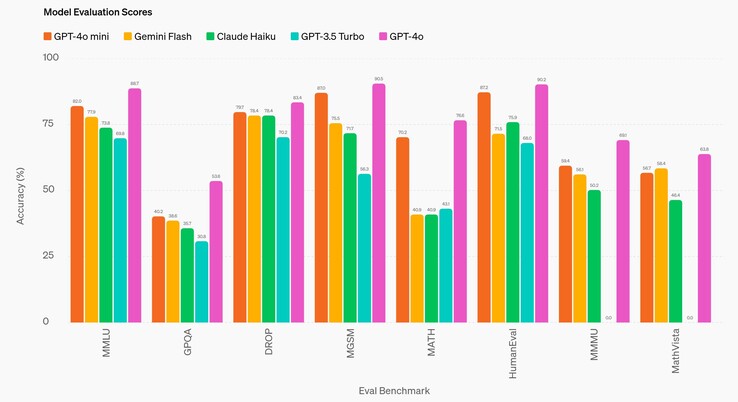

En una comparación directa con GPT-4oel mejor LLM de OpenAI publicado en 2024, el GPT-4o mini arroja sistemáticamente respuestas menos precisas. Cuando se compara con GPT-3.5 Turbo de 2022, GPT-4o mini obtiene sistemáticamente mejores resultados. En una variedad de pruebas comparativas de IA de nivel universitario (DROP, HumanEval, MATH, MathVista, MGSM, MMLU, y MMMU), el modelo responde a las preguntas con precisión aproximadamente entre el 60 y el 80% de las veces. Sólo en la prueba de nivel de doctorado (GPQA) que su precisión desciende a aproximadamente el 40%, es decir, sólo ligeramente mejor que la de una persona no experta que busque una respuesta en Internet.

Es importante destacar que, mientras que GPT-4o tiene un precio de 5 $/1M de tokens de entrada y 15 $/1M de tokens de salida, GPT-4o mini tiene un precio de 0,15 $/1M de entrada y 0,60 $/1M de salida (1000 tokens son aproximadamente 750 palabras). Esto es más barato que aproximadamente ochenta LLM comuness en uso hoy en día, con la excepción de mistral-embed.

GPT-4o mini tiene una ventana de contexto de entrada de 128K tokens, que es la cantidad de texto que se puede analizar a la vez, por lo que el análisis de grandes volúmenes de documentos empresariales y jurídicos está limitado. La ventana de salida está limitada a 16K tokens. El modelo también tiene un límite de conocimiento de octubre de 2023, por lo que las noticias, los acontecimientos y los descubrimientos que se produzcan después de esta fecha son desconocidos para la IA y no pueden utilizarse para responder a las preguntas.

Los lectores que sigan esperando que los robots humanoides de la IA se sinceren y cocinen para ellos, como el prototipo 1X Neotendrán que conformarse mientras tanto con robots sin IA(como esta aspiradora de Amazon).

Fuente(s)

18 de julio de 2024

GPT-4o mini: avanzando en inteligencia rentable

Presentamos nuestro modelo pequeño más rentable

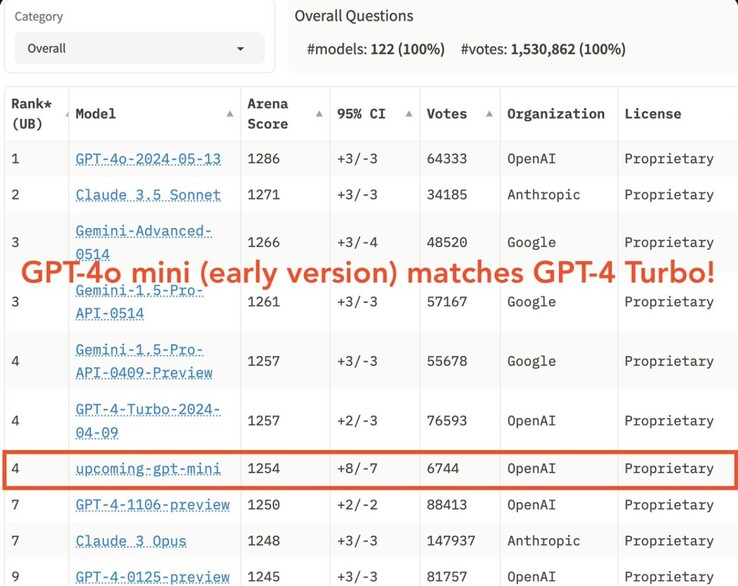

OpenAI se compromete a hacer que la inteligencia sea lo más ampliamente accesible posible. Hoy anunciamos GPT-4o mini, nuestro modelo pequeño más rentable. Esperamos que GPT-4o mini amplíe significativamente la gama de aplicaciones construidas con IA al hacer la inteligencia mucho más asequible. GPT-4o mini obtiene una puntuación del 82% en MMLU y actualmente supera a GPT-41 en preferencias de chat en la clasificación LMSYS(se abre en una nueva ventana). Su precio es de 15 céntimos por millón de fichas de entrada y 60 céntimos por millón de fichas de salida, un orden de magnitud más asequible que los modelos de frontera anteriores y más de un 60% más barato que GPT-3.5 Turbo.

GPT-4o mini permite una amplia gama de tareas gracias a su bajo coste y latencia, como las aplicaciones que encadenan o paralelizan varias llamadas al modelo (por ejemplo, la llamada a varias API), pasan un gran volumen de contexto al modelo (por ejemplo, la base de código completa o el historial de conversaciones) o interactúan con los clientes mediante respuestas de texto rápidas y en tiempo real (por ejemplo, los chatbots de atención al cliente).

En la actualidad, GPT-4o mini admite texto y visión en la API, y en el futuro admitirá entradas y salidas de texto, imagen, vídeo y audio. El modelo tiene una ventana de contexto de 128K tokens, admite hasta 16K tokens de salida por solicitud y tiene conocimientos hasta octubre de 2023. Gracias al tokenizador mejorado que comparte con GPT-4o, la manipulación de texto no inglés es ahora aún más rentable.

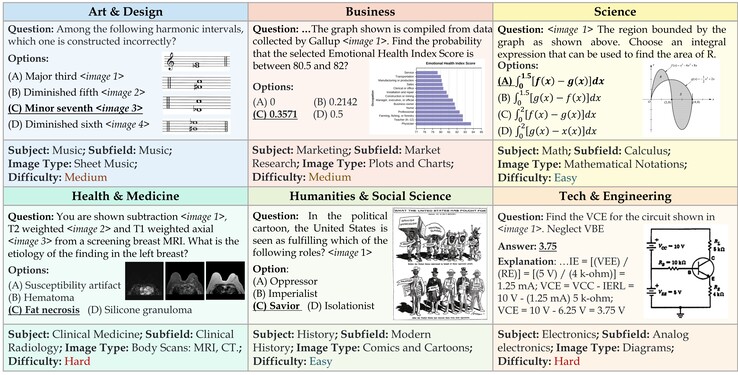

Un modelo pequeño con inteligencia textual superior y razonamiento multimodal

GPT-4o mini supera a GPT-3.5 Turbo y a otros modelos pequeños en los puntos de referencia académicos tanto en inteligencia textual como en razonamiento multimodal, y admite la misma gama de idiomas que GPT-4o. También demuestra un gran rendimiento en la llamada a funciones, lo que puede permitir a los desarrolladores crear aplicaciones que obtengan datos o realicen acciones con sistemas externos, y un mejor rendimiento en contextos largos en comparación con GPT-3.5 Turbo.

GPT-4o mini ha sido evaluado en varios puntos de referencia clave2.

Tareas de razonamiento: GPT-4o mini es mejor que otros modelos pequeños en tareas de razonamiento que implican tanto texto como visión, obteniendo una puntuación del 82,0% en MMLU, un punto de referencia de inteligencia y razonamiento textual, en comparación con el 77,9% de Gemini Flash y el 73,8% de Claude Haiku.

Competencia matemática y de codificación GPT-4o mini destaca en tareas de razonamiento matemático y codificación, superando a los anteriores modelos pequeños del mercado. En MGSM, que mide el razonamiento matemático, GPT-4o mini obtuvo una puntuación del 87,0%, frente al 75,5% de Gemini Flash y el 71,7% de Claude Haiku. GPT-4o mini obtuvo un 87,2% en HumanEval, que mide el rendimiento en codificación, frente al 71,5% de Gemini Flash y el 75,9% de Claude Haiku.

Razonamiento multimodal: GPT-4o mini también muestra un fuerte rendimiento en MMMU, una evaluación de razonamiento multimodal, con una puntuación del 59,4% en comparación con el 56,1% de Gemini Flash y el 50,2% de Claude Haiku.

Como parte de nuestro proceso de desarrollo del modelo, trabajamos con un puñado de socios de confianza para comprender mejor los casos de uso y las limitaciones de GPT-4o mini. Nos asociamos con empresas como Ramp(opens in a new window) y Superhuman(opens in a new window) que descubrieron que GPT-4o mini funcionaba significativamente mejor que GPT-3.5 Turbo en tareas como la extracción de datos estructurados de archivos de recibos o la generación de respuestas de correo electrónico de alta calidad cuando se les proporciona el historial de hilos.

Medidas de seguridad incorporadas

La seguridad se incorpora a nuestros modelos desde el principio y se refuerza en cada paso de nuestro proceso de desarrollo. En el preentrenamiento, filtramos (se abre en una nueva ventana) la información de la que no queremos que nuestros modelos aprendan o emitan, como discursos de odio, contenido para adultos, sitios que principalmente agregan información personal y spam. En el post-entrenamiento, alineamos el comportamiento del modelo con nuestras políticas utilizando técnicas como el aprendizaje por refuerzo con retroalimentación humana (RLHF) para mejorar la precisión y fiabilidad de las respuestas de los modelos.

GPT-4o mini lleva incorporadas las mismas mitigaciones de seguridad que GPT-4o, que evaluamos cuidadosamente mediante evaluaciones automatizadas y humanas de acuerdo con nuestro Marco de Preparación y en línea con nuestros compromisos voluntarios. Más de 70 expertos externos en campos como la psicología social y la desinformación pusieron a prueba la GPT-4o para identificar los riesgos potenciales, que hemos abordado y de los que tenemos previsto compartir los detalles en la próxima tarjeta del sistema GPT-4o y en el cuadro de mando de preparación. Las conclusiones de estas evaluaciones de expertos han ayudado a mejorar la seguridad tanto de GPT-4o como de GPT-4o mini.

Basándose en estos aprendizajes, nuestros equipos también trabajaron para mejorar la seguridad de GPT-4o mini utilizando nuevas técnicas informadas por nuestra investigación. GPT-4o mini en la API es el primer modelo que aplica nuestro método de jerarquía de instrucciones(opens in a new window), que ayuda a mejorar la capacidad del modelo para resistir jailbreaks, inyecciones de prompt y extracciones de prompt del sistema. Esto hace que las respuestas del modelo sean más fiables y contribuye a que sea más seguro utilizarlo en aplicaciones a escala.

Seguiremos vigilando cómo se utiliza GPT-4o mini y mejoraremos la seguridad del modelo a medida que identifiquemos nuevos riesgos.

Disponibilidad y precios

GPT-4o mini ya está disponible como modelo de texto y visión en la API de asistentes, la API de finalización de chat y la API de lotes. Los desarrolladores pagan 15 céntimos por 1M de tokens de entrada y 60 céntimos por 1M de tokens de salida (aproximadamente el equivalente a 2500 páginas de un libro estándar). Tenemos previsto poner en marcha el ajuste para GPT-4o mini en los próximos días.

En ChatGPT, los usuarios Free, Plus y Team podrán acceder a GPT-4o mini a partir de hoy, en lugar de GPT-3.5. Los usuarios de empresa también tendrán acceso a partir de la semana que viene, en línea con nuestra misión de hacer que los beneficios de la IA sean accesibles para todos.

Lo que viene

En los últimos años, hemos sido testigos de notables avances en la inteligencia de la IA junto con reducciones sustanciales de los costes. Por ejemplo, el coste por token de GPT-4o mini se ha reducido en un 99% desde text-davinci-003, un modelo menos capaz introducido en 2022. Estamos comprometidos a continuar esta trayectoria de reducción de costes al tiempo que mejoramos las capacidades de los modelos.

Imaginamos un futuro en el que los modelos se integren a la perfección en todas las aplicaciones y en todas las páginas web. GPT-4o mini está allanando el camino para que los desarrolladores construyan y escalen potentes aplicaciones de IA de forma más eficiente y asequible. El futuro de la IA es cada vez más accesible, fiable e integrado en nuestras experiencias digitales diarias, y estamos entusiasmados por seguir liderando el camino.

Autor

OpenAI

Agradecimientos

Líderes: Jacob Menick, Kevin Lu, Shengjia Zhao, Eric Wallace, Hongyu Ren, Haitang Hu, Nick Stathas, Felipe Petroski Such

Líder del programa: Mianna Chen

Contribuciones anotadas en openai.com/gpt-4o-contributions/

Notas a pie de página

1

Desde el 18 de julio de 2024, una versión anterior de GPT-4o mini supera a GPT-4T 01-25.

2

Los números de Eval para GPT-4o mini se calculan utilizando nuestro repo simple-evals(opens in a new window) con el asistente de mensajes del sistema API. Para los modelos de la competencia, tomamos el número máximo sobre su número informado (si está disponible), la tabla de clasificación HELM(opens in a new window) y nuestra propia reproducción mediante simple-evals.

Top 10 Análisis

» Top 10 Portátiles Multimedia

» Top 10 Portátiles de Juego

» Top 10 Portátiles de Juego ligeros

» Top 10 Portátiles Asequibles de Oficina/Empresa

» Top 10 Portátiles de Juego Ligeros

» Top 10 Portátiles de Oficina/Empresa Premium

» Top 10 Estaciones de Trabajo

» Top 10 Subportátiles

» Top 10 Ultrabooks

» Top 10 Convertibles

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Tablets de menos de 250 Euros

» Top 10 Phablets (>5.5")

» Top 10 Smartphones

» Top 10 Smartphones (≤5")

» Top 10 Smartphones de menos de 300 Euros

» Top 10 Smartphones de menos de 120 Euros

» Top 10 Portátiles de menos de 1000 Euros

» Top 10 Portátiles de menos de 500 Euros

» Top 10 Portátiles de menos de 300 Euros

» Los Mejores Displays de Portátiles Analizados por Notebookcheck